منافس غوغل بارد و chat GPT من الصين… جرب روبوت DeepSeek مجاناً الآن يدعم العربي والبرمجة

–.أطلقت DeepSeek، شركة مقرها الصين والتي تهدف إلى “فك رموز الذكاء الاصطناعي العام بفضولها”، نموذج DeepSeek LLM، وهو نموذج يحتوي على 67 مليار معلمة تم تدريبه بدقة من البداية على مجموعة بيانات تتألف من 2 تريليون رمز.

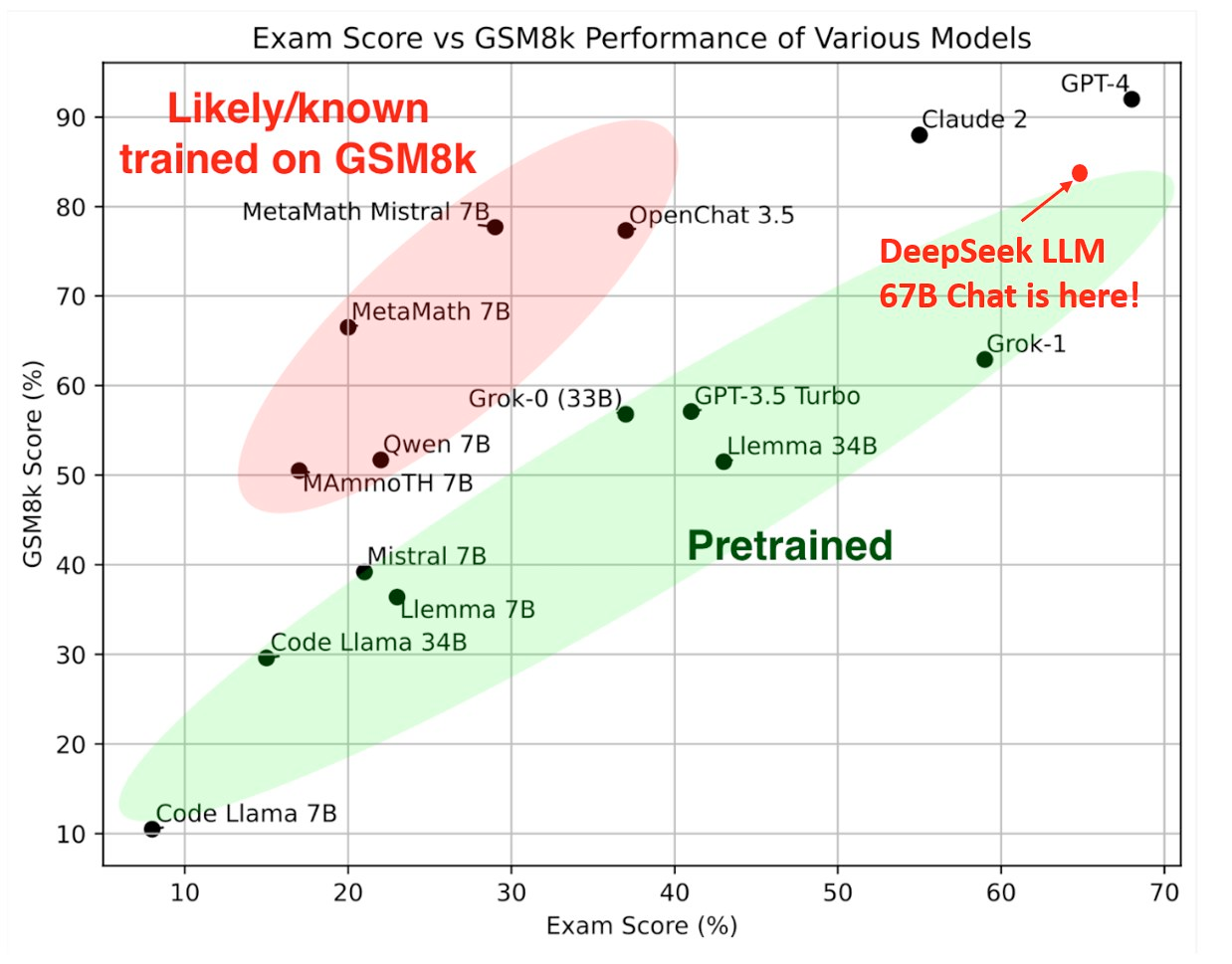

أظهر DeepSeek LLM 67B Base قدرات فائقة، متفوقًا على Llama 2 70B Base في مجالات رئيسية مثل الاستدلال، والبرمجة، والرياضيات، وفهم اللغة الصينية. وبشكل خاص، يتم التركيز على كفاءته في البرمجة من خلال درجة ممتازة في تقييم البشري Pass@1 والتي بلغت 73.78، وفي الرياضيات، حقق درجات ملحوظة، بما في ذلك GSM8K 0-shot: 84.1 وMath 0-shot: 32.6.

يتم التأكيد على قدرات تعميم النموذج من خلال الحصول على درجة استثنائية تبلغ 65 في امتحان المدرسة الثانوية الوطنية المجرية الصعبة.

يتم إصدار نماذج DeepSeek LLM 7B/67B، بما في ذلك الإصدارات الأساسية وإصدارات الدردشة، للعامة على GitHub وHugging Face وأيضًا AWS S3. يتم توفير الوصول إلى نقاط التفتيش الوسيطة أثناء عملية التدريب على النموذج الأساسي، مع خضوع الاستخدام لشروط الترخيص المحددة.

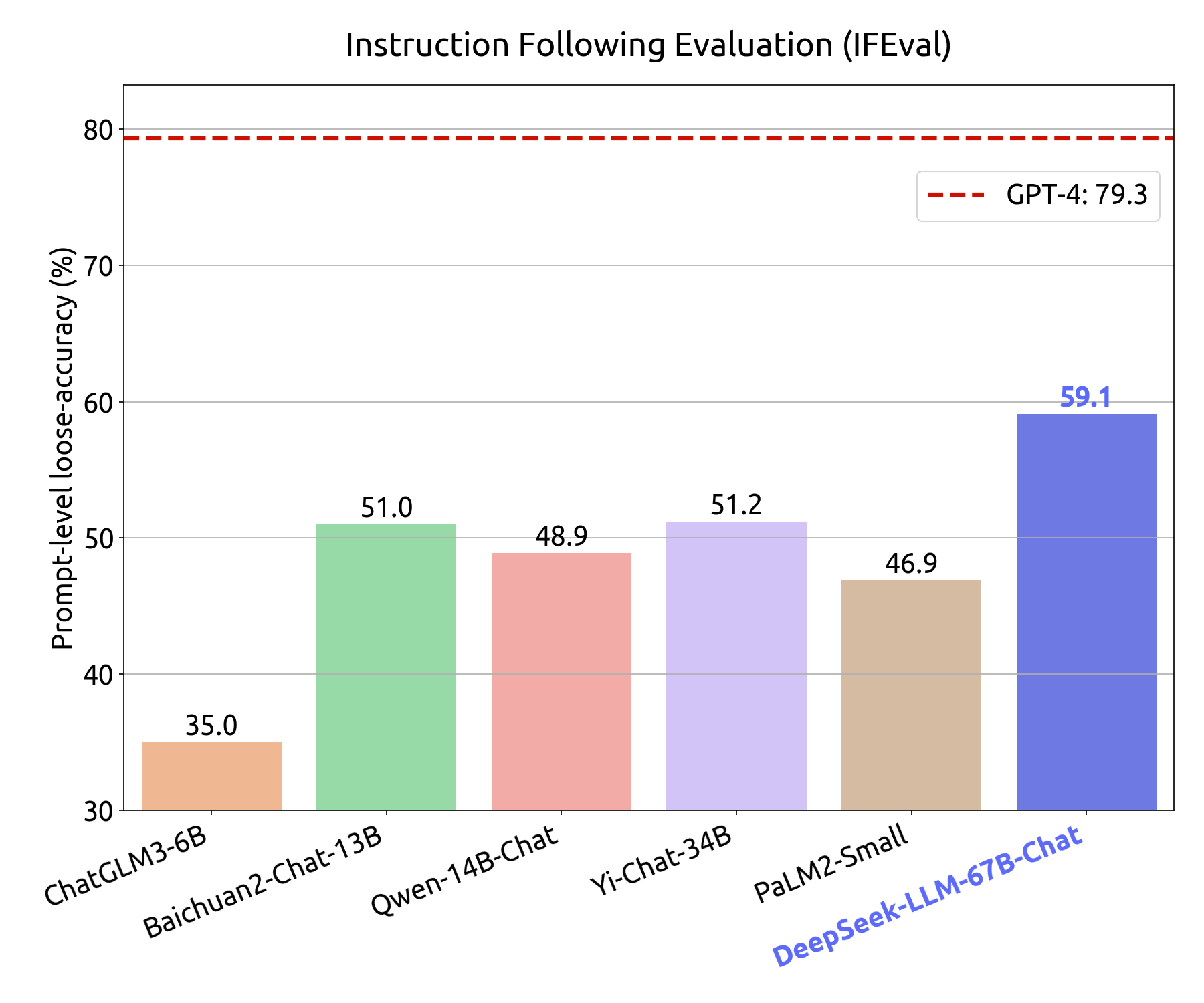

تم إجراء تقييمات متعمقة على النماذج الأساسية ونماذج الدردشة، ومقارنتها بالمعايير الحالية. تكشف النتائج عن تفوق DeepSeek LLM على LLaMA-2، وGPT-3.5، وClaude-2 في مقاييس مختلفة، مما يعرض براعتها في اللغتين الإنجليزية والصينية. ويمتد التقييم إلى اختبارات لم يسبق لها مثيل، بما في ذلك امتحان المدرسة الثانوية الوطنية المجرية، حيث يُظهر DeepSeek LLM 67B Chat أداءً متميزًا. وقد أثبتت تجربة أسئلة الاختيار من متعدد قدرتها على تعزيز الأداء المعياري، وخاصة في المعايير الصينية متعددة الاختيارات. من خلال دمج 20 مليون سؤال صيني متعدد الاختيارات، يُظهر DeepSeek LLM 7B Chat نتائج محسنة في MMLU وC-Eval وCMMLU. يتضمن التدريب المسبق لـ DeepSeek LLM مجموعة بيانات واسعة، تم تنسيقها بدقة لضمان الثراء والتنوع. تستخدم البنية، المشابهة لـ LLaMA، نماذج فك ترميز المحولات ذات الانحدار التلقائي مع آليات انتباه فريدة من نوعها. يتم نشر عملية ما قبل التدريب، مع تفاصيل محددة حول منحنيات فقدان التدريب والمقاييس القياسية، للجمهور، مع التركيز على الشفافية وإمكانية الوصول. في الآونة الأخيرة، كشفت شركة علي بابا، عملاق التكنولوجيا الصيني، أيضًا عن ماجستير إدارة أعمال خاص بها يسمى Qwen-72B، والذي تم تدريبه على بيانات عالية الجودة تتكون من رموز 3T وأيضًا نافذة سياق موسعة بطول 32 كيلو بايت. ليس هذا فحسب، بل أضافت الشركة أيضًا نموذجًا لغويًا أصغر، Qwen-1.8B، مروجًا له كهدية لمجتمع البحث.

🌟 Performance Highlights

🏆 DeepSeek LLM 67B Base surpasses Llama2 70B Base in general capabilities.

💻 DeepSeek LLM 67B Chat performs exceptionally well in coding, mathematics, and reasoning. pic.twitter.com/Y9uVNYAq2l— DeepSeek (@deepseek_ai) November 29, 2023